Les pipelines ETL (Extract → Transform → Load) et ELT (Extract → Load → Transform) sont devenus la colonne vertébrale de l’intégration et de la valorisation des données.

Alors que la volumétrie, la variété et la vélocité des données explosent, choisir la bonne approche conditionne :

La qualité des analyses,

La réactivité des services,

Et le coût global de la plateforme.

Dans cet article, nous verrons pourquoi ces méthodes restent centrales, leurs forces, leurs limites, et comment choisir la plus adaptée à votre projet.

Depuis une dizaine d’années, le passage au cloud et l’essor des data warehouses ont bouleversé la chaîne d’intégration.

Historiquement, l’approche ETL (transform before load) dominait :

👉 On préparait les données avant de les charger, ne conservant que des jeux prêts à l’emploi.

Aujourd’hui, avec :

La baisse des coûts de stockage,

La puissance de calcul massivement parallèle,

L’approche ELT (load first) prend le dessus, en effectuant les transformations directement dans l’entrepôt cloud.

Le défi ?

Maximiser la fraîcheur des données

Réduire le time-to-insight

Maîtriser les coûts

Tout en assurant une gouvernance rigoureuse et une qualité de données irréprochable

Une mauvaise décision peut entraîner :

Des pipelines trop lents

Des doublons de données

Une dette technique coûteuse

Dans une chaîne ETL :

→ Extraction → Traitements (nettoyage, normalisation, enrichissement) → Chargement dans la base d’analyse

Dans une chaîne ELT :

→ Extraction → Chargement des données brutes dans l’entrepôt cloud → Transformation via SQL ou un orchestrateur comme dbt

| Critère | ETL | ELT |

|---|---|---|

| Latence | Plus élevée (transformation avant chargement) | Faible (chargement quasi immédiat) |

| Complexité infra | Serveurs ETL dédiés + stockage intermédiaire | Infrastructure centralisée dans le Data Warehouse |

| Gouvernance | Contrôle fort avant l’entrée dans le DW | Données brutes → besoin d’une gouvernance solide |

| Coût de stockage | Faible (on ne stocke que les données « propres ») | Peut exploser si tout est historisé |

| Scalabilité transfo | Limite des serveurs ETL | Élasticité MPP du DW (massively parallel processing) |

Un barista ouvre chaque matin ses sacs de grains, trie ceux qui sont abîmés, pèse le reste, et les range soigneusement. Il prépare ensuite les cafés avec ce lot déjà trié.

Si un nouveau sac arrive à midi, il ne peut pas être utilisé : tout est déjà préparé.

👉 Approche ETL : tri préalable, stock propre, mais peu de flexibilité.

Un jour, le barista change de méthode :

Il verse tous les sacs dans un grand silo, sans tri préalable.

À chaque commande, il prélève la dose, trie rapidement les grains défectueux, puis les moud.

Un lot reçu à midi est servi à 12h15.

👉 Approche ELT : plus de fraîcheur, plus d’adaptabilité, tri à la volée.

Transposition au monde de la data :

ETL = données triées avant stockage → qualité garantie mais rigide

ELT = tout stocker → flexibilité et rapidité, mais gouvernance postérieure

Avant de choisir une méthode, évaluez vos besoins réels :

Volume de données

Fréquence de mise à jour

Niveau de contrôle requis

Budget technique

Cas pour préférer l’ETL :

✔ Volumes modestes

✔ Réglementation stricte (filtrage à l’entrée)

✔ Équipe maîtrisant déjà des outils de transformation

➡️ Vous garantissez la qualité avant ingestion, limitez le stockage et réduisez les erreurs en amont.

Cas pour privilégier l’ELT :

✔ Données en flux continu

✔ Réactivité quasi temps réel

✔ Stockage cloud peu coûteux

➡️ Vous gagnez en flexibilité, appliquez les transformations à la demande, et adaptez les requêtes à la volée.

-> Versionner le code de transformation

-> Déclencher des tests automatiques à chaque modification

-> Documenter les tables (origine, étapes traversées, qualité)

-> Commencer par un mini-projet pilote (2 ou 3 sources) pour tester les performances, les coûts et la prise en main

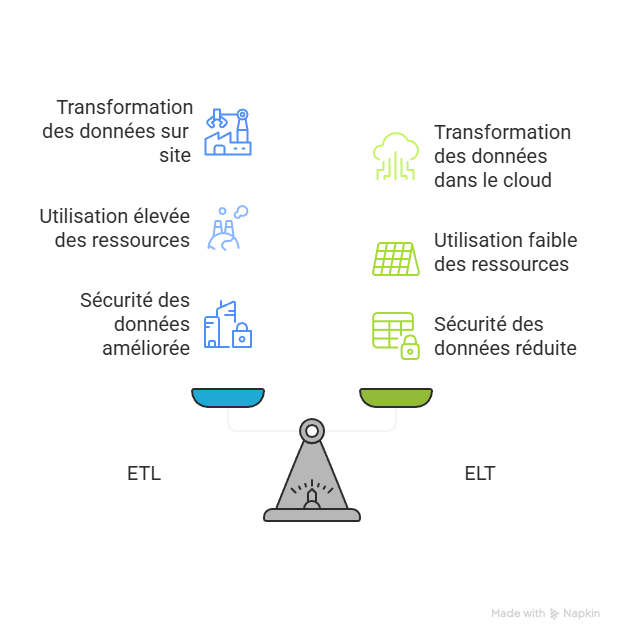

ETL : garantit la qualité en amont, mais limite la souplesse

ELT : maximise la fraîcheur et l’agilité, au prix d’un contrôle différé

Le choix dépend :

Du volume de données,

Du rythme d’actualisation,

Des contraintes réglementaires,

Et de vos capacités techniques.

Avec la montée en puissance des entrepôts cloud, l’approche ELT ouvre la voie à une analyse temps réel, une expérimentation accélérée, et une prise de décision plus agile.

💡Pour les équipes data, le mot d’ordre est clair :

Commencer petit, mesurer les gains réels, et adopter des pratiques solides pour faire de la technologie une vraie valeur métier.

Jamila Cherkaoui, Assistante Data Analyst chez Kaizzen

Vous avez besoin d’un renseignement et d’accompagnement sur le déploiement des solutions Cloud Microsoft ?